Neuropsychologie

Die Neuropsychologie ist ein interdisziplinäres Fachgebiet an der Schnittstelle von Psychologie und Neurowissenschaften . Sie erforscht, wie Strukturen und Funktionen des Gehirns unser Erleben, Denken und Verhalten beeinflussen – und was passiert, wenn diese Prozesse gestört sind. Dabei geht es um zentrale Fragen des Menschseins: Wie erinnern wir? Wie treffen wir Entscheidungen? Was passiert im Gehirn bei Emotionen, Sprache oder Aufmerksamkeit? Und wie wirken sich Schädigungen, Erkrankungen oder Entwicklungsstörungen auf diese Fähigkeiten aus?

Im Zentrum der neuropsychologischen Arbeit stehen sowohl grundlagenwissenschaftliche Fragestellungen als auch die Anwendung in der klinischen Praxis – etwa in der Diagnostik und Therapie von Schlaganfällen, Demenzen, Epilepsien oder traumatischen Hirnverletzungen. Die Methoden reichen von standardisierten Testverfahren über bildgebende Verfahren bis hin zu computergestützten Simulationen kognitiver Prozesse.

Um die Komplexität und Vielfalt der Neuropsychologie zu verdeutlichen, finden sich auf dieser Seite auch konkrete Fallbeispiele, die das Fachgebiet entscheidend geprägt haben.

So etwa der Fall des berühmten Patienten H.M., der nach einer Operation zur Behandlung seiner Epilepsie unfähig wurde, neue Erinnerungen zu bilden – ein Schicksal, das der Neuropsychologin Brenda Milner bahnbrechende Einsichten in die Funktionsweise des Gedächtnisses ermöglichte.

Oder der Fall aus dem Buch “Der Mann, der seine Frau mit einem Hut verwechselte” des Neurologen Oliver Sacks: Ein Patient, der trotz intakter Intelligenz und Sprache nicht mehr erkannte, was er sah, und seine Umwelt nur noch als abstrakte Einzelmerkmale wahrnahm – ein eindrucksvolles Beispiel für die Bedeutung intakter visueller und semantischer Verarbeitung im Gehirn.

Neben diesen historischen und literarisch bekannten Fällen stellt diese Seite auch aktuelle Erkenntnisse und Forschungsansätze der modernen Neuropsychologie vor: etwa zu neuronaler Plastizität, digitalen Diagnoseverfahren oder neuen Therapieformen für neurokognitive Störungen.

Der Patient H.M.

Es ist das Jahr 1953. In einem Operationssaal in Hartford, Connecticut, liegt ein 27-jähriger Mann namens Henry Molaison auf dem Tisch – nichts ahnend, dass sein Gehirn bald zu einem der meistuntersuchten der Medizingeschichte gehören wird. Seit seiner Kindheit leidet H.M., wie er später nur genannt werden sollte, unter schweren epileptischen Anfällen, die weder Medikamente noch andere Therapien kontrollieren können. In einem letzten, verzweifelten Versuch, sein Leiden zu lindern, wagt der Neurochirurg William Scoville das Unerhörte: Er entfernt beidseitig große Teile des medialen Temporallappens, darunter den Hippocampus, die Amygdala und angrenzende kortikale Strukturen. Was folgt, ist eine wissenschaftliche Zeitenwende.

Die Anfälle verschwinden – und mit ihnen ein Teil von H.M. selbst. Von einem Moment auf den nächsten verliert er die Fähigkeit, neue bewusste Erinnerungen zu bilden. Gespräche verschwinden nach Sekunden aus seinem Bewusstsein. Begegnungen sind für ihn immer die ersten. Während seine Intelligenz, Sprachfähigkeit und Wahrnehmung intakt bleiben, entsteht eine tiefe anterograde Amnesie, die ihn zeitlebens begleiten wird. Die Operation hatte ihn von seiner Epilepsie geheilt – und ihn zugleich in einer Gegenwart ohne Zukunft gefangen.

Doch gerade diese Tragik macht H.M. zum bedeutendsten Fall der frühen Neuropsychologie. Die kanadische Neuropsychologin Brenda Milner, die ihn jahrelang erforscht, erkennt: Das Gedächtnis ist kein monolithischer Speicher, sondern ein komplexes System verschiedener Module. H.M. kann motorische Fertigkeiten erlernen – etwa das Zeichnen von Formen im Spiegel – ohne sich je daran zu erinnern, geübt zu haben. Diese Entdeckung beweist erstmals, dass es verschiedene Gedächtnissysteme im Gehirn gibt: Das deklarative Gedächtnis, das bewusste Erinnern von Fakten und Ereignissen, ist vom Hippocampus abhängig. Das prozedurale Gedächtnis, das für Bewegungen und Routinen zuständig ist, dagegen nicht.

H.M. wurde zum unfreiwilligen Pionier der Gedächtnisforschung. Jahrzehntelang führten Wissenschaftler*innen Untersuchungen durch, sein Gehirn wurde nach seinem Tod in über 2.400 hauchdünne Scheiben zerschnitten und digitalisiert – ein makaberer, aber aufschlussreicher Akt der Wissenschaft. Heute wissen wir dank ihm, dass der Hippocampus eine Schlüsselrolle bei der Konsolidierung von Erinnerungen spielt, jedoch nicht für das Abrufen älterer, bereits gespeicherter Inhalte verantwortlich ist.

Was bleibt, ist ein einzigartiger Fall, der die Frage stellt: Was macht unser Selbst aus, wenn unser Gedächtnis schweigt? H.M. konnte erzählen, was in seiner Kindheit geschehen war, doch er konnte nicht erinnern, dass er es erzählt hatte Er lebte in einem fortwährenden Jetzt, intakt im Denken, aber getrennt von der Zeit.

Die Geschichte von H.M. ist nicht nur ein medizinisches Mysterium, sondern ein philosophisches Echo auf die Fragilität unserer Identität. Und sie ist ein Denkmal dafür, wie ein einziger menschlicher Verlust zum kollektiven Wissensgewinn werden kann.

Eric Kandel betont, dass das Gehirn auch im hohen Alter plastisch bleibt, sich aber auf molekularer Ebene messbare Veränderungen vollziehen. In seinen Arbeiten zur altersassoziierten Gedächtnisschwäche zeigt er u. a., dass im Gyrus dentatus des Hippocampus der Histon-Regulator RbAp48 mit den Jahren abnimmt; dieses Defizit beeinträchtigt synaptische Plastizität und damit Lernleistungen. Wird RbAp48 in alten Mäusegehirnen experimentell angehoben, normalisiert sich das Gedächtnis – ein Hinweis, dass altersbedingter Abbau reversibel sein kann und sich von Alzheimer-Pathologie unterscheidet.

Auf Vorträgen unterstreicht Kandel außerdem, dass körperliche Aktivität und lebenslanges Lernen die plastischen Reserven im Alter fördern: Bewegung steigert u. a. den Osteocalcin-Spiegel, der als „genereller Gedächtnis-Booster“ wirkt, und geistige Herausforderung hält die synaptische Architektur flexibel. Sein Rat lautet deshalb: „Don’t retire early.“

Hemisphärische

Asymmetrie

als zentrales Prinzip

des Gehirns

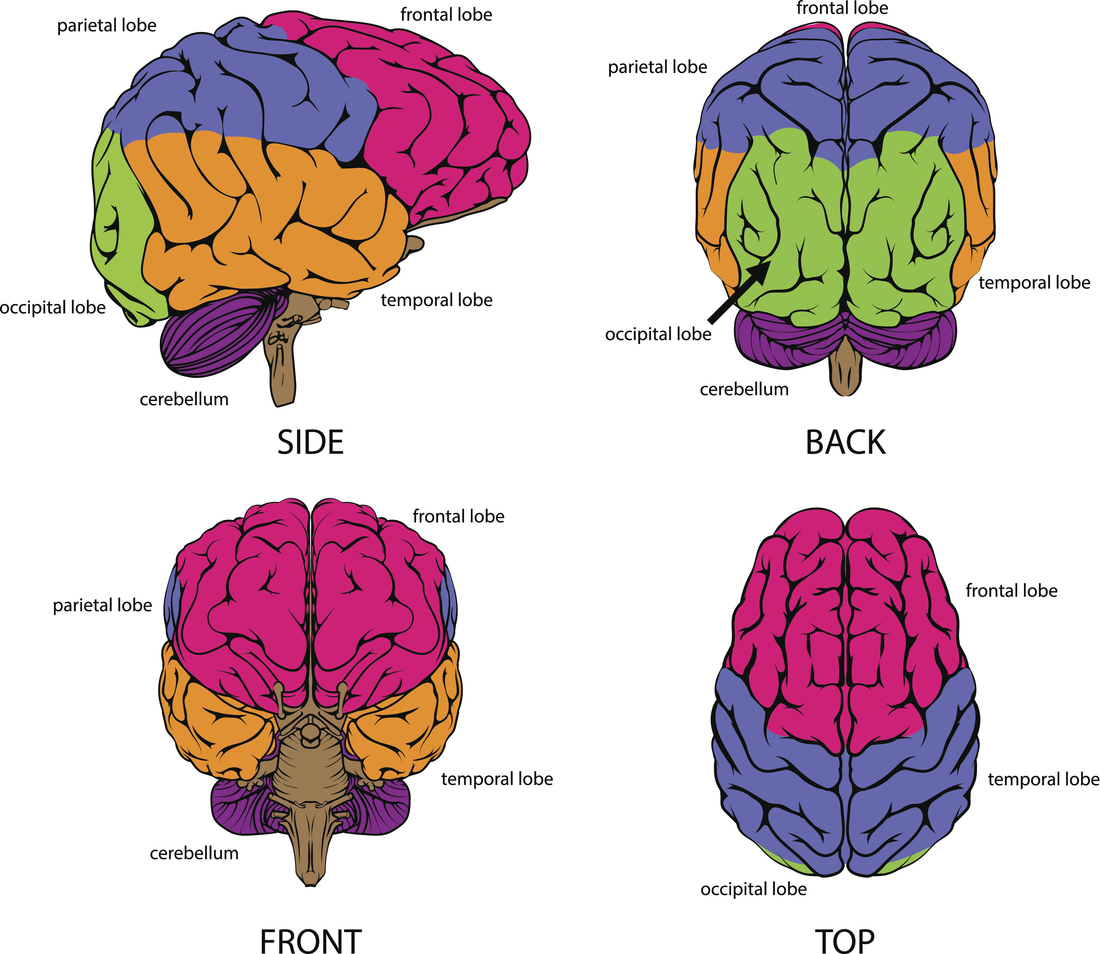

Als Faustregel gilt, dass wir typischerweise eine dominante Hemisphäre für bestimmte Arten kognitiver Operationen haben. Solche spezialisierten Zuständigkeiten zeigen sich besonders deutlich bei emotionaler Reaktionsfähigkeit und visuell-räumlicher Aufmerksamkeit sowie bei bewusster Problemlösung und Sprachfähigkeiten. Diese funktionalen Asymmetrien werfen die Frage nach dem besonderen Zweck und der neuroinformatischen Infrastruktur auf, die den Menschen bei der Evolution zur Wahrnehmung, zum Verständnis und zur Navigation in der Welt befähigt.

Wie trägt die Hemisphärenspezialisierung zur menschlichen Kognition bei?

Einzigartige menschliche kognitive Fähigkeiten entstehen durch das flexible Zusammenspiel spezifischer lokaler neuronaler Module mit hemisphärischen Asymmetrien in der funktionalen Spezialisierung. Hier diskutieren wir, wie diese rechnergestützten Designprinzipien ein Gerüst für einige der fortschrittlichsten kognitiven Operationen bilden, wie beispielsweise das semantische Verständnis der Weltstruktur, logisches Denken und die Kommunikation über Sprache. Wir ziehen Parallelen zu Dual-Processing-Theorien der Kognition und konzentrieren uns dabei auf Kahnemans System 1 und System 2. Wir schlagen die Integration dieser Ideen mit der Global Workspace Theory vor, um die dynamische Weiterleitung von Informationsprodukten zwischen beiden Systemen zu erklären. Die Vertiefung des aktuellen Verständnisses der Besonderheit neurokognitiver Asymmetrie kann die nächste Welle neurowissenschaftlich inspirierter künstlicher Intelligenz auslösen.

Funktionale Lateralisierung hängt von spezifischen Kontextanforderungen ab

Es ist eine der etabliertesten Erkenntnisse der neurowissenschaftlichen Forschung, dass die linke Hemisphäre den übergeordneten Sprachprozessor beherbergt ( Broca, 1865 ; Wernicke, 1874 ). Diese Annahme impliziert jedoch nicht, dass die rechte Hemisphäre grundsätzlich wortblind ist ( Lindell, 2006 ). Tatsächlich beruhen metalinguistische Verarbeitungsaspekte wie die Verarbeitung von Metaphern oder die Verarbeitung untergeordneter Bedeutungen mehrdeutiger Wörter auf einer stärkeren Beteiligung rechtshemisphärischer Regionen (siehe Hartwigsen und Siebner, 2012 ). In manchen Fällen hängt die Lateralisierung von der spezifischen Funktion eines bestimmten linguistischen Prozesses ab.

Soziale Kognition und Sprache

Die kognitive Evolution des Menschen wurde durch soziale und sprachliche Fähigkeiten vorangetrieben. Ein herausragendes Merkmal sozialer Kognition ist die Fähigkeit, die Gedanken, Überzeugungen und Verhaltensweisen anderer Menschen zu erschließen. Schon Kleinkinder im Alter von sieben Monaten scheinen zu impliziten mentalen Schlussfolgerungen fähig zu sein. Soziale Kognition ist eng mit Sprachverständnis und -produktion verknüpft. Beide Prozesse scheinen für den zwischenmenschlichen Austausch entscheidend zu sein. Das Verständnis der semantischen Implikationen eines gegebenen Kontextes ist insbesondere für soziale Interaktionen relevant.

Wie das Gehirn Sprache entschlüsselt – Neueste Einsichten aus Neurowissenschaft und Neuropsychologie

Gesprochene Sprache beginnt als bloßes Schallereignis am Trommelfell und endet – kaum 600 Millisekunden später – als bewusste Bedeutung im präfrontalen Handlungsnetz. Zwischen diesen beiden Punkten entfaltet das Gehirn heute nachweisbar ein präzise getaktetes Zusammenspiel spezialisierter Module, das weit über die klassische Broca-/Wernicke-Binarität hinausgeht.

Schon in den frühen 2000ern stellte David Poeppel (NYU / Max-Planck) seine Theorie des asymmetric sampling in time vor. In einer PLoS Biology-Studie von 2024 konnte sein Team mit intracortikalen Ableitungen zeigen, dass der auditive Kortex Sprachsignale tatsächlich parallel in zwei Zeitscheiben zerlegt: 30–50 ms-Fenster koppeln an γ-Rhythmen und extrahieren Konsonanten, 200–300 ms-Fenster (θ-Band) kodieren Silbenrhythmus und Intonation. Damit ist bewiesen, dass schon die früheste Stufe des Systems oszillatorisch abgestimmt ist – Sprache wird nicht kontinuierlich, sondern „getaktet“ verarbeitet.

Auf dieser phonetischen Grundlage baut das Dual-Stream-Modell von Greg Hickok und Poeppel auf. Ein dorsaler Pfad (planum temporale → inferiorer Parietallappen → Broca-Region) knüpft Lautrepräsentationen an Artikulationspläne; ein ventraler Pfad (anteriorer Temporallappen → orbitofrontaler Kortex) transformiert dieselben Laute in lexikalisch-semantische Codes. Hickoks großes Review im Handbook of Clinical Neurology (2022) – inzwischen Standardlektüre – belegt mit DTI-Traktografien, dass der dorsale Strang auch syntaktische Sequenzen codiert, während der ventrale semantische Vorhersagen generiert. Damit wird Sprache schon früh zweigleisig organisiert: Wie etwas gesagt wird (Motorik) separiert sich von was etwas bedeutet (Semantik).

Die Feinmechanik dieser Aufteilung liefert Angela D. Friederici. Ihre MEG-Arbeiten (u. a. NeuroImage 2023) zeigen, dass bereits ~200 ms nach Wortbeginn eine ELAN-Signatur im linken pars opercularis und anterioren Temporallappen aufleuchtet – ein Hinweis darauf, dass das Gehirn zuerst einen syntaktischen Rohbau erstellt. Erst gut 150 ms später folgt die semantische N400-Welle in posterioren temporalen Arealen. Damit ist die Reihenfolge klar: Grammatik hat Vorfahrt vor Bedeutung.

Doch Grammatik allein genügt nicht. Die angemessene Auswahl einer Bedeutung im jeweiligen Kontext übernimmt ein semantisches Kontrollnetz, auf das Matthew Lambon Ralph (Cambridge) und Evelina Fedorenko (MIT) in ihren fMRT-Arbeiten von 2024 verweisen. Unter hoher Ambiguität springt ein Bogen aus ventro-lateraler Präfrontalrinde, dorsal-medialem Präfrontalkortex und Angulargyrus an, der irrelevante Assoziationen unterdrückt und kontextadäquate Bedeutungen hervorhebt – ein Befund, der klinisch erklärt, warum Patienten mit frontalen Läsionen zwar Wörter kennen, aber Redewendungen nicht mehr treffend benutzen.

Schriftliche Sprache dockt an dasselbe Netzwerk an, nutzt aber ihren eigenen Einstiegskanal: Stanislas Dehaene belegt mit Langzeit-fMRT (eNeuro 2024), dass der visuelle Wortformbereich im occipito-temporal Cortex schon nach wenigen Jahren intensiven Lesens hochselektiv auf Buchstabencluster reagiert – ein Paradebeispiel für „neuronales Recycling“ vorhandener Objekterkennungsareale.

Sprache ist außerdem selten rein auditiv. Uta Noppeney (Birmingham) demonstrierte 2024 in PLoS Biology, dass sichtbare Lippen- oder Handbewegungen noch bevor der Laut eintrifft prädiktive Aktivität im auditorischen Kortex auslösen. Diese multisensorische Kopplung hilft vor allem älteren Zuhörern, Sprachsignale im Störlärm zu verstehen – ein Beleg für prädiktive Kodierung im Sprachsystem.

Fazit

Das heutige Bild der Sprachverarbeitung ist ein hierarchisch oszillierendes, bilateral verteiltes und prädiktiv arbeitendes Netzwerk, in dem:

- gamma- und theta-Rhythmen die Lautanalyse takten (Poeppel),

- ein Dual-Stream-Routing Laut in Motorik vs. Bedeutung aufspaltet (Hickok),

- eine ultraschnelle Syntaxprüfung dem Lexikon den Weg bereitet (Friederici),

- ein präfrontal-temporales Kontrollnetz Bedeutungen zielgerecht auswählt (Lambon Ralph / Fedorenko),

- der visuelle Wortformbereich Schrift an die Lautpfade koppelt (Dehaene) und

- multisensorische Vorhersagen das System laufend justieren (Noppeney).

Vorfahrt für die Grammatik: Die Neurokognition des Sprachverstehens

Sprache entfaltet sich im Gehirn als ein hochkomplexes Netzwerk aus phonologischer Verarbeitung, syntaktischer Strukturierung und semantischer Bedeutungszuweisung. Bereits in weniger als einer Sekunde prüfen unsere Neuronen, ob ein Satz grammatisch korrekt ist, ordnen thematische Rollen zu und entschlüsseln schließlich den Sinn.

Brocas und Wernickes Erbe

Schon Mitte des 19. Jahrhunderts deckte Paul Broca die Lokalisation des Artikulationszentrums in der linken unteren Stirnwindung auf, als er bei seinem Patienten „Tan“ eine massive Schädigung in diesem Bereich fand. Kurz darauf identifizierte Carl Wernicke im Schläfenlappen das Zentrum für Sprachverständnis, indem er Patienten mit Aphasie untersuchte, die zwar flüssig sprachen, aber Bedeutungen nicht mehr erfassten.

Friedericis syntaktische Automatik

Heute belegt das Team um Angela D. Friederici mit fMRT- und EEG-Analysen, dass das Gehirn zuerst die Grammatik dekodiert – noch bevor es Wörter und Bedeutungen verarbeitet. In Experimenten mit vier Satztypen von korrekt bis vollkommen unverständlich zeigen Aktivierungsmuster:

- Der vordere linke Temporallappen signalisiert Abweichungen von der erwarteten Syntax.

- Ein spezifischer ELAN-Effekt (Early Left Anterior Negativity) bei etwa 200 ms markiert die automatische Erkennung grammatischer Fehler.

- Bei rein semantischen Anomalien schlägt das N400-Signal nach rund 400 ms an, gefolgt von einer P600-Reaktion, wenn Grammatik und Bedeutung in die gemeinsame Nachbearbeitung gehen.

Diese zeitliche Zweistufigkeit – erst Syntax, dann Semantik – entspricht einem seriellen Modell, das unser Kurzzeitgedächtnis vor Überlastung schützt, indem es eingehende Sprachinformationen in grammatische Häppchen segmentiert.

Automatisierung und Universalgrammatik

Friedericis Befunde belegen, dass die ELAN-Reaktion hochgradig automatisiert ist: Selbst wenn 80 % der Sätze im Test bewusst falsch waren, reagierte das Gehirn gleichermaßen auf jede Abweichung, unabhängig von bewusster Aufmerksamkeit. Dies stützt die Annahme einer angeborenen Universalgrammatik im Sinne Chomskys – wenngleich alternative Modelle auf die enorme Lernfähigkeit des Gehirns verweisen, das durch wiederholte Exposition statistische Muster extrahiert.

Entwicklung im Kindesalter

EEG-Studien mit Kindern zeigen, dass erst um das neunte Lebensjahr herum die ELAN-Reaktion jene Geschwindigkeit und Stärke erreicht, die man von Erwachsenen kennt. Bis dahin verbessern sich syntaktische Erkennungsprozesse schrittweise: Fünfjährige haben nur eine schwache oder verzögerte ELAN, während Achtjährige bereits ähnliche Muster wie Erwachsene aufweisen.

Integration rechter Hemisphäre und Prosodie

Entgegen früheren Annahmen aktiviert Sprache nicht nur die linke, sondern auch die rechte Hemisphäre – insbesondere bei der Verarbeitung von Prosodie und Aufmerksamkeit. Je komplexer oder unerwarteter die sprachliche Aufgabe, desto stärker mischt sich das rechte Stirnhirn mit ein, um Melodie, Betonung und Fokus zu regulieren.

In der Summe zeigen diese neurowissenschaftlichen Befunde: Unser Sprachverstehen ist kein singuläres Modul, sondern ein orchestriertes Zusammenspiel spezialisierter Areale und zeitlich abgestimmter Prozesse. Die Grammatik erhält dabei Vorfahrt, noch bevor Wortbedeutung und Kontext zur vollen Entfaltung kommen.